Напротив, библиометрические критерии плохо подходят для:

1) сравнения результативности ученых, работающих в различных областях науки;

2) сравнения институтов и университетов в целом;

3) определения важности и «приоритетности» отдельных областей знания;

4) сравнения результативности молодых и более опытных ученых без учета времени работы в науке и изменения в традиции цитирования со временем.

Не следует придавать значения несущественным количественным различиям в библиометрических показателях. Интересно, что именно этот пункт активно обсуждается в известном отчете математиков и дискуссии вокруг отчета [2]. Там зачастую речь идет о 30–50%-ных различиях. В то же время в России чаще всего речь идет об отличии в десятки раз по индексу цитирования или в разы в импакт-факторе журналов; т.е. многие из обсуждаемых в мировой литературе доводов критиков не имеют отношения к российской ситуации. При оценке к данным следует применять сглаживающие процедуры.

52

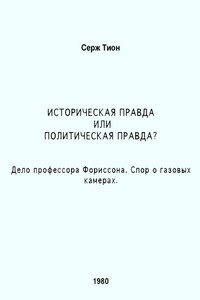

Рис. Л.Мельника

Отдельно отметим, что показатели, основанные на цитируемости, малопригодны для оценки успешности текущей научной работы. В этом случае можно использовать число публикаций с учетом импакт-фактора журнала, количества соавторов, позиции в списке авторов и т.п.

При использовании индикаторов важно различать, с какой целью проводится экспертиза:

1) премирование,

2) стимулирование,

3) оценка будущей продуктивности,

4) оценка способности выполнить конкретную задачу.

Разные задачи эффективно решаются с использованием разных критериев. В частности, для премирования целесообразно использовать суммарные показатели за большие периоды времени, для стимулирования — показатели, отражающие текущую активность, для оценки будущей продуктивности — комбинацию этих показателей, отражающую динамику публикационной активности. Конкретный набор применяемых критериев и методика работы с ними в каждом конкретном случае должны тщательно обсуждаться с участием активно работающих ученых и после этого включаться в регламенты экспертизы.

Как показывает практика реализации систем выплаты стимулирующих надбавок на основании наукометрических показателей внутри научных и образовательных учреждений (например, надбавки по ПРНД в РАН), в силу как объективных, так и субъективных причин внутриучрежденческие системы выплаты надбавок не способны обеспечить качественное и единообразное проведение разумной государственной политики. В то же время в мире имеются примеры эффективно работающих общегосударственных открытых систем стимулирующих выплат (фактически систем выдачи индивидуальных грантов на основании в первую очередь публикационных показателей). В связи с этим одной из возможностей может быть создание открытой общегосударственной системы выплаты стимулирующих надбавок, основанной на заявительном принципе, которая облегчит в свою очередь переход к новой кадровой системе в науке и образовании (см. [4]).

В заключение следует подчеркнуть, что разумное применение формальных критериев для первичного отбора экспертов, проведения некоторых описанных выше видов экспертизы, а также для контроля результатов оценки способно в итоге существенно повысить уровень развития науки в нашей стране. Для проведения качественной экспертизы кроме адекватного использования формальных критериев требуется модернизация механизма принятия решений. Для этого необходимо выработать действенные, а не формальные механизмы учета мнения научного сообщества при принятии решений, и следует в обязательном порядке привлекать к работе над концептуальными документами и регламентами ученых, работающих на мировом уровне и потому лучше других понимающих специфику работы в своей области науки.

Авторы благодарят за обсужде ние Дмитрия Горбунова, Егора За дереева, Алексея Иванова.

Примечания

[1] «ФЦП Кадры — гладко было на бумаге» «Троицкий вариант» от 27 октября 2009 г.

www.scientific.ru/journal/news/2009/1009/kadry3.html

53

[2] Доклад Международного математического союза совместно с Международным советом по промышленной и прикладной математике и Институтом математической статистики.

http://arxiv.org/abs/0910.3529